第1章 为什么要自己动手做大数据系统(略)

第2章 项目背景及准备(略)

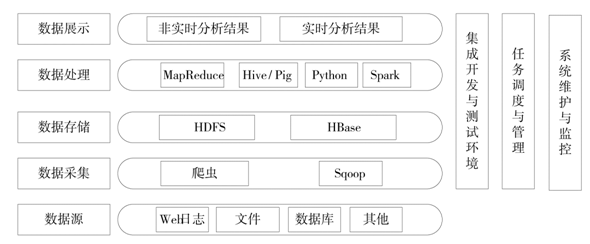

项目总体框架图,从数据获取->数据存储->数据处理->数据分析与展示

第3章 大数据环境搭建和配置

3.1 各组件功能说明

3.1.1 各种数据源的采集工具

3.1.2 企业大数据存储工具

3.1.3 企业大数据系统的数据仓库工具

3.1.4 企业大数据系统的分析计算工具

3.1.5 企业大数据系统的数据库工具

3.2 大数据系统各组件安装部署配置

3.2.1 安装的前期准备工作

3.2.2 Hadoop基础环境安装及配置

3.2.3 Hive安装及配置

3.2.4 Sqoop安装及配置

3.2.5 Spark安装及配置

3.2.6 Zookeeper安装及配置

3.2.7 HBase安装及配置

3.3 自动化安装及部署说明

3.3.1 自动化安装及部署整体架构设计

3.3.2 大数据系统自动化部署逻辑调用关系

3.4 本章小结

第4章 大数据的获取

4.1 使用爬虫获取互联网数据

4.2 Python和Scrapy 框架的安装

4.3 抓取和解析招聘职位信息

4.4 职位信息的落地

4.5 两个爬虫配合工作

4.6 让爬虫的架构设计更加合理

4.7 获取数据的其他方式

4.8 使用Sqoop同步论坛中帖子数据

4.9 本章小结

第5章 大数据的处理

5.1 Hive是什么

5.2 为什么使用Hive做数据仓库建模

5.3 飞谷项目中Hive建模步骤

5.3.1 逻辑模型的创建

5.3.2 物理模型的创建

5.3.3 将爬虫数据导入stg_job表

5.4 使用Hive进行数据清洗转换

5.5 数据清洗转换的必要性

5.6 使用HiveQL清洗数据、提取维度信息

5.6.1 使用HQL清洗数据

5.6.2 提取维度信息

5.7 定义Hive UDF封装处理逻辑

5.7.1 Hive UDF的开发、部署和调用

5.7.2 Python版本的UDF

5.8 使用左外连接构造聚合表rpt_job

5.9 让数据处理自动调度

5.9.1 HQL的几种执行方式

5.9.2 Hive Thrift服务

5.9.3 使用JDBC连接Hive

5.9.4 Python调用HiveServer服务

5.9.5 用crontab实现的任务调度

5.10 本章小结

第6章 大数据的存储

6.1 NoSQL及HBase简介

6.2 HBase中的主要概念

6.3 HBase客户端及JavaAPI

6.4 Hive数据导入HBase的两种方案

6.4.1 利用既有的JAR包实现整合

6.4.2 手动编写MapReduce程序

6.5 使用Java API查询HBase中的职位信息

6.5.1 为什么是HBase而非Hive

6.5.2 多条件组合查询HBase中的职位信息

6.6 如何显示职位表中的某条具体信息

6.7 本章小结

第7章 大数据的展示

7.1 概述

7.2 数据分析的一般步骤

7.3 用R来做数据分析展示

7.3.1 在Ubuntu上安装R

7.3.2 R的基本使用方式

7.4 用Hive充当R的数据来源

7.4.1 RHive组件

7.4.2 把R图表整合到Web页面中

7.5 本章小结

第8章 大数据的分析挖掘

8.1 基于Spark的数据挖掘技术

8.2 Spark和Hadoop的关系

8.3 在Ubuntu上安装Spark集群

8.3.1 JDK和Hadoop的安装

8.3.2 安装Scala

8.3.3 安装Spark

8.4 Spark的运行方式

8.5 使用Spark替代Hadoop Yarn引擎

8.5.1 使用spark-sql查看Hive表

8.5.2 在beeline客户端使用Spark引擎

8.5.3 在Java代码中引用Spark的ThriftServer

8.6 对招聘公司名称做全文检索

8.6.1 从HDFS数据源构造JavaRDD

8.6.2 使用Spark SQL操作RDD

8.6.3 把RDD运行结果展现在前端

8.7 如何把Spark用得更好

8.8 SparkR组件的使用

8.8.1 SparkR的安装及启动

8.8.2 运行自带的Sample例子

8.8.3 利用SparkR生成职位统计饼图

8.9 本章小结